Quanto sto per raccontare è assolutamente accaduto, anche se non si conoscono il luogo ed il momento esatto della vicenda, il nome delle persone o tecnologie coinvolte, il tipo di strumenti utilizzati, la causa scatenante, il destino vissuto dal prodotto finale. Negli anni ’80, l’esercito degli Stati Uniti si trovò innanzi ad un dilemma: come sfruttare le nuove tecnologie informatiche per aumentare non soltanto la letale precisione delle proprie armi, ma anche per accrescere il potenziale di sopravvivenza di chi pilotava i carri armati? La risposta, a quanto pare, fu ben presto chiara ed immediata: tramite l’intelligenza artificiale. Poiché era possibile, almeno in via teorica, addestrare un computer per assistere gli equipaggi in quello che è sempre stato il singolo compito più importante nei contesti bellici, ovvero avvistare il nemico, prima che lui potesse far lo stesso a noi. Possibile, sia chiaro, ma non semplice. In quanto noi non umani ben difficilmente potremmo affermare di comprendere alla perfezione ciò che ci consente d’individuare la forma e/o l’essenza delle cose, come enunciato nella frase: “Quella che noi chiamiamo una rosa, con qualsiasi altro nome, profumerebbe altrettanto dolcemente” e l’evidenza, parimenti a ciò che scrisse Shakespeare del più amato fiore, non determina la pura verità. Così avvenne, all’interno di una qualche cupa installazione di ricerca militare, che alcune le menti più brillanti del Pentagono fossero instradate alla progettazione di un computer differente da qualsiasi altro mai creato prima. Che fosse in grado di interpretare le immagini, ma non in modo matematico (la conta dei pixel o dei colori, l’individuazione delle auguste geometrie) quanto sulla base di una semplice domanda monotipica: “Dietro a quel particolare albero, c’è per caso un carro sovietico, in agguato?” Ah, magnifico, persino carico di un vago senso d’ironia. Pare quasi di vedere gli scienziati ed ingegneri in camice bianco, con il loro album fotografico di 100 panorami, alcuni con sorpresa cingolata, altri privi di elementi minacciosi di alcun tipo. Intenti ad inserirli, in rapida sequenza, nella fessura orizzontale di uno scanner primitivo. All’altro capo del quale non c’era una singola entità artificiale, ma diverse interconnesse, secondo il metodo e la prassi che si usa ancora oggi, per (tentare di) riconoscere calligrafie, parole pronunciate ad alta voce, i volti delle persone presenti in una scena. Li chiamano network neurali. E pur essendo *ancòra notevolmente meno efficaci di un vero cervello umano, non sono in alcun modo meno misteriosi, o difficili da dominare. Pensate di essere, per un momento, un singolo neurone sospeso nella guaina mielinica di un cranio, dotato delle cognizioni necessarie a riconoscere soltanto il blu. Trovandovi di fronte ad un qualcosa di verde, non potrete far altro che passarlo al vostro vicino, il quale forse noterà l’assenza del giallo, oppure quella del rosso e così via, fino a trovare la risposta. Ma un carro armato è molto più complesso di così, perché può trovarsi in mille angolazioni differenti, essere coperto parzialmente dal paesaggio…Passarono i giorni, le settimane. A fronte di un frenetico processo di addestramento, si giunse infine al punto in cui, senza timor d’errori, il sistema riconosceva e contrassegnava tra le 100 foto quelle da considerare “pericolose” senza il minimo margine d’errore. Il numero dei successi continuava ad aumentare. La missione era…Riuscita? Furono chiamati il capo-progetto, il generale d’armata, forse addirittura il presidente degli Stati Uniti. Per inserire dinnanzi a loro, non senza un certo grado di aspettativa e pathos, una nuova serie di foto nel computer, nuovamente suddivise tra bucolici contesti e luoghi prossimi all’agguato veicolare. Ebbene, a quanto pare, il computer stavolta fallì nell’identificare il dovuto, con una percentuale di successi molto inferiore a quanto mai fosse successo in precedenza. Furono effettuati degli studi, nuovi saggi e dimostrazioni. Finché non si giunse all’orrida realtà: che nelle fondamentali 100 foto utilizzate inizialmente, c’era un tratto distintivo ben più evidente dell’eventuale presenza del nemico. Perché tutte quelle senza carro armato, erano state effettuate in una giornata di sole piuttosto intenso. Mentre le altre, con il cielo parzialmente coperto. Ciò che il computer stava identificando, dunque, era semplicemente la luce ambientale della scena! Non è terribile, tutto ciò? Personalmente, trovo che sia una progressione dalle analogie profondamente nichiliste. Ecco una macchina creata per “comprendere” di avere uno scopo, ma la quale non è in grado di capire quale questo, in effetti, sia. E s’impegna quotidianamente, per l’intero segmento del suo attimo di gloria, nel perseguire un obiettivo che non si dimostra quello designato dai creatori. Prima di essere per sempre spenta, poi dimenticata.

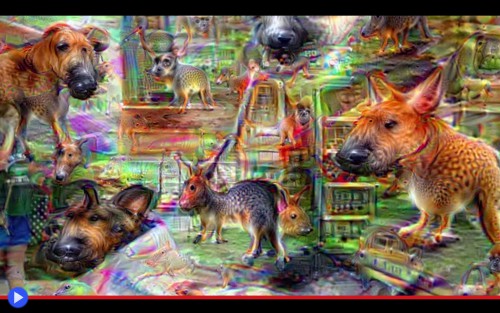

Spettri che aleggiano nella sequenza dei concetti, spiriti analogici del mondo. Nessuno può ben dire, a ragione, di avere chiari nella mente i suoi modelli, l’uccello primordiale che può permetterti di riconoscere il passero e il gabbiano, o il primo albero, la pietra da cui vengono tutte le altre. Tranne un computer, che da simili concetti viene schiacciato e totalmente definito, condizionato in ciò che riesce o meno a fare. Verso l’inizio dello scorso luglio, con la massima sorpresa della maggior parte di noi, il tema dei network neurali è ritornato nuovamente in auge, grazie al rilascio pubblico dell’ennesimo “progetto collaterale” del colosso Google, frutto dell’intuizione avuta dal suo team di ricerca e sviluppo, al quale viene sempre lasciato un certo grado di autonomia. Il nome commerciale scelto per l’idea è Deep Dream, anche se Deep Nightmare, forse, sarebbe stato più appropriato. Perché se il suo funzionamento è frutto di un processo relativamente utile, ciò che ne deriva pare invece il risultato di una potente droga psicotropica, in grado di distruggere le sacre forme delle cose. Per ricostruirle in qualcosa di…Nuovo, diverso. Il peso dei Chihuahua sopra il petto, con i loro artigli acuminati. L’ansimare dei San Bernardo che percuotono la mente, con le grandi lingue rosa, come punti di fuga dalla nostra tipica realtà. Il sibilo nel vento dei levrieri, scalpitanti tra le pieghe dello spazio-tempo. Tutto questo e molto altro, mostrato al mondo in elaborazioni grafiche analoga a quella del video di Pouff – Grocery Trip (mostrato in apertura) in cui una semplice uscita per far spese si trasforma in un trip che non sarà semplice dimenticare.

Per comprenderne l’origine, dobbiamo tornare a quel progetto americano del sistema d’individuazione dei carri armati. Ora immaginate di sostituire questi ultimi con qualcosa di più innocuo, perché il grande pubblico, naturalmente, vuole essere tranquillizzato. Ad esempio: animali. Tutti amano gli animali! Soltanto che ai nostri giorni, ciò va da se, la capacità di calcolo ed elaborazione dei computer è cresciuta a dismisura, per cui il dispositivo non verrà sottoposto alla visione di soltanto 100 o 400 cani, ma piuttosto 1.000, 10.000…. Per poi chiedergli, ad infinite riprese, in questa nuova foto, Fido c’è? Giusto, giusto, si, no, sbagliato. E invece qui, computer, Fido ce lo vedi?

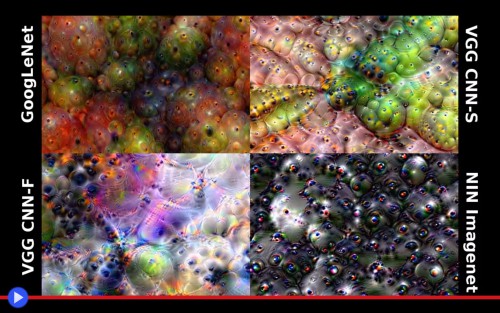

Abbiamo esordito definendo il sistema dei network neurali come misterioso e inconoscibile, doti che comunque gli appartengono ma sempre meno, soprattutto col passar del tempo. Ciò perché nei fatti, si è scoperto, è possibile chiedere al computer di rendere manifesti i punti intermedi del suo ragionamento, ovvero mostrare tramite la sua principale interfaccia con gli umani (lo schermo) i punti in cui gli riusciva di identificare totalmente, o parzialmente, il cane o il carro armato. Tale approccio sarà molto utile, in futuro, ad evitare tragici fraintendimenti come quello del fattore climatico, diventato erroneamente un tratto distintivo in quel fatidico giorno di oltre due decadi fà. Ciò che risulta da una tale messa “in chiaro” del processo d’identificazione, è già di per se piuttosto affascinante: questo tipo di intelligenze artificiali, come loro massima prerogativa, lavorano ad ondate successive. Così avviene che il primo dei neuroni (entità del tutto indipendente) inizi a lavorare sui margini e le linee, producendo quella serie di volute simili a del fumo che si vedono talvolta, nelle immagini in cui Deep Dream, o prodotti equivalenti, hanno trovato un’applicazione più leggera. Mentre per gradi, lentamente, i neuroni sovrastanti iniziano a individuare quanto richiesto. Il che non significa che uno scienziato, o ancor più probabilmente, un creativo che lavora fuori o dentro Google, non possano scegliere di abbassare la soglia selettiva, chiedendo al computer di identificare come cane tutto ciò che possa anche soltanto vagamente, molto lontanamente assomigliargli. Per poi mostrarlo, spietatamente, a schermo.

L’effetto di una tale progressione è assurdo e al tempo stesso disumanizzante. Detersivi che abbaiano, scaffali che guaiscono. Persone di passaggio che diventano, come uno shoggoth lovercraftiano, dotati d’innumerevoli occhi neri e musi globulari. Chiunque abbia mai sofferto d’emicrania, con o senza mal di testa, probabilmente ben ricorda l’alone sfarfallante che penetra nel campo visivo, modificando le cose familiari in flash di luce, che concorrono per cancellare il senso logico di ciò che si ha di fronte. Ora immaginate per un attimo, soltanto un secondo, che ciascuna di queste forme insensate giunga a trasfigurarsi nel volto di un qualche amichevole animale, pronto a fissarvi con aspettativa dal frigorifero e dai muri. Se davvero gli esseri umani potessero sperimentare un tale grado di distaccamento dalla logica comune, tanto varrebbe prendere l’LSD, assieme al latte di mattina…

Questo è forse uno dei paradigmi che diventeranno più importanti nel giro dei prossimi quattro, cinque secoli: più le macchine diventano intelligenti, meno avranno bisogno di noi. Nel momento in cui si crea un software che debba interpretare le immagini, gli si da carta bianca nel comprendere che cosa, in effetti, sia degno di essere impiegato come tratto distintivo. In un caso di luglio che ha sollevato attenzione mediatica estremamente significativa, venendo anche citato in un articolo del Telegraph, l’algoritmo di riconoscimento impiegato dal motore di ricerca di Google finì per attribuire ad alcune foto in primo piano dell’afroamericano Jacky Alciné, ripreso assieme ai suoi amici, la denominazione di “[gruppo di] gorilla” mostrando apparenti propositi di discriminazione razziale. Quando in realtà semplicemente, il sistema stava l’equilibrio dei colori e delle forme nell’unico modo che aveva a sua disposizione, in quel caso totalmente errato. Soltanto l’introduzione di un repertorio fotografico più ampio, assieme ad un controllo approfondito dell’output prodotto da meccanismi conformi al metodo Deep Dream, potranno permettere di ridurre il verificarsi futuro di simili fraintendimenti.

Se poi da questo dovesse derivare l’esperienza psichica di un mondo infestato da cani o gorilla nella nebbia, dovremo necessariamente farcene una ragione. Purché non vengano sostituiti da pericolosi carri armati…

- Link al più popolare dei siti presso cui inviare le proprie immagini, allo scopo di ottenere un’elaborazione sul modello di Deep Dream nel giro di appena 15 secondi.

- Dreamscope, un’alternativa più sofisticata che risulta disponibile anche in forma di app per cellulare.

- La community di Reddit che contiene un catalogo delle creazioni degli utenti.