Non più soltanto Pippo e Paperino. Dai laboratori della Disney Research di Zurigo, divisione tecnologica del grande colosso dell’intrattenimento associata al politecnico del capoluogo del cantone omonimo, provengono ogni anno alcune significative invenzioni dalle evidenti potenzialità commerciali, che tuttavia sono così distanti dal quotidiano, e di avveniristica concezione, da ritrovarsi tranquillamente associabili al mondo della scienza pura. Robot che camminano sui muri, algoritmi semplificati per il movimento della stoffa, sistemi virtuali per il calcolo dei castelli di sabbia, approcci alternativi per animare le marionette… Tutto questo presentato al pubblico, spesso durante prestigiose fiere internazionali della tecnologia, con un’assoluto candore e completezza, senza porsi il problema di proteggere la propria proprietà intellettuale, con finalità difficilmente associabili alla mera generazione di un profitto. Eventi come il SIGGRAPH (Special Interest Group on GRAPHics and Interactive Techniques) la cui edizione estiva del 2016 si è appena conclusa presso la città di Anaheim, nell’Orange County californiana, e per la quale Disney ha nuovamente presentato una proposta che si colloca nel campo tanto spesso rivisitato della stampa tridimensionale. Si tratta, essenzialmente, della risposta alla seguente domanda: sarebbe possibile, per un hobbista, una piccola azienda o un dipartimento universitario, creare con semplicità un quantità variabile di oggetti, dalla forma altamente specifica e per di più, in technicolor? Fino ad oggi, la risposta sarebbe stato un chiaro ed immediato “no”. Perché anche con l’attuale semplificazione intercorsa del processo per creare dei prodotti a partire dall’estrusione e/o deposizione della plastica, successivamente al raffreddamento di quest’ultima non è possibile che prevedere una seguente procedura per limare, togliere le parti in eccedenza e quindi, solo successivamente, applicarsi di buona lena con le proprie vernici d’ordinanza. Non per niente, uno degli ambiti in cui l’impiego di simili macchinari ha colpito maggiormente il grande pubblico è la realizzazione di miniature per i giochi da tavolo, per le quali è già previsto, è viene considerato addirittura desiderabile, l’uso diretto del pennello da parte dell’utente finale. Ma un conto è fare le cose per scelta, ed un altro perché non ci sono alternative. Ed una valida soluzione, per chi forse la stava ancora cercando, eccola finalmente qui per noi. Si chiama computational thermoforming, ed ha MOLTO a che vedere con la realizzazione della grafica per film e videogiochi.

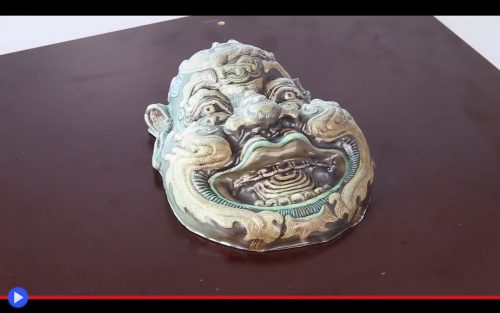

È una visione affascinante, che molti siti e blog hanno già definito “magica” per probabile associazione con l’aggettivo che da sempre Disney ama attribuirsi nelle sue campagne di marketing o nel branding ufficiale. Sarebbe del resto difficile negargli simili prerogative, per lo meno in questo specifico, rivoluzionario caso. Su quella che parrebbe essere una scatola di metallo, è posta una stampa di forma pressoché quadrata raffigurante in 2D i soggetti più diversi: un ceppo di legno, un pezzo di pane, la carrozzeria di un’automobilina, la maschera del teatro cinese che raffigura il generale Wei Qi Gong, nume tutelare delle abitazioni. Quindi l’operatore preme un tasto fuori dall’inquadratura, e le immagini sembrano all’improvviso prendere vita, sollevandosi verso l’alto in una ragionevole approssimazione della forma reale di ciò che stavano rappresentando. E non è finita qui: uno sbuffo d’aria, un brusco suono, e subito dopo l’estrusione rientra in parte, aderendo in modo puntuale alla perfetta forma che palesemente era desiderabile allo scopo. Tutto è perfetto e pienamente allineato, la forma con l’immagine, il profilo con la sua profondità. Manca soltanto di chiarire come, effettivamente, un simile fenomeno possa essersi compiuto sotto i nostri spalancati occhi?!